这个案例主要是利用tfa框架Sequence to Sequence Model Architecture中的Attention以及Encoder-Decoder方法实现神经机器翻译(Neural Machine Translation,NMT),当然翻译的准确性不可能像BERT之类的那么好,但...

”nlp RNN 机器翻译 attention“ 的搜索结果

RNN+Attention实现Seq2Seq中英文机器翻译

机器翻译是自然语言处理领域的一个重要任务,它旨在将一种自然语言翻译成另一种自然语言。传统的机器翻译方法包括规则基于的方法和统计基于的方法。然而,这些方法在处理复杂句子和捕捉上下文信息方面存在局限性。 ...

神经机器翻译技术NMT 主要特点:输出是单词序列而不是单个单词,并且可能输出序列的长度与输入序列的长度不同 机器翻译的实现过程 1. 数据预处理 乱码处理 我们通常所用的空格是 \x20 ,是在标准ASCII可见字符 0x20~...

思路 文本处理,这里我是以eng_fra的文本为例,每行是english[tab]french,以tab键分割。获取文本,清洗。...再将开始标志通过传给Decoder结合Encoder的隐层和每层的输出(期间用到attention,下面详细讲解)

NLP入门,基于PyTorch框架实现一个中文到英文的机器翻译的小demo【附全部源代码】

在两个机器翻译任务上的实验表明,这些模型在质量上更优越,同时更具并行性,需要的训练时间明显减少。我们的模型在2014年WMT英德翻译任务中达到28.4 BLEU,比现有的最佳结果(包括集成部分)提高了2个BLEU以上。在WMT...

Paper:Transformer模型起源—2017年的Google机器翻译团队—《Transformer:Attention Is All You Need》翻译并解读-20230802版 目录 相关文章 Paper:Transformer模型起源—2017年的Google机器翻译团队—...

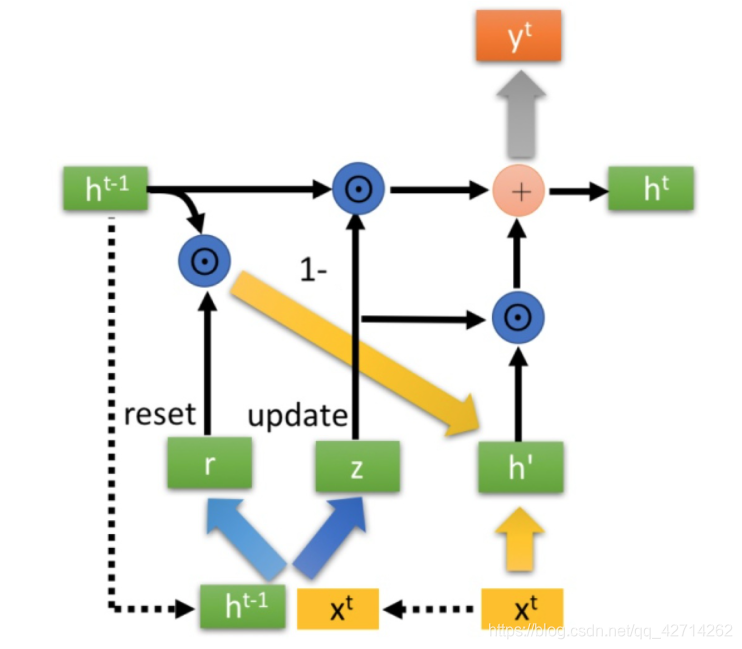

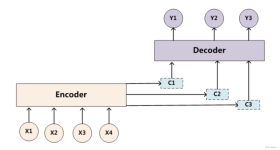

首先简单回顾一下之前说的机器翻译模型,一般的机器翻译模型都由encoder与一个decoder组成,模型图如下: 注意力模型Attention 如果考虑普通的encoder-decoder模型,我们将会遇到这样的问题,即decoder只接受...

神经机器翻译 attention 宗成庆 本课程为中国科学院研究生院专业基础课

Luong+Attention完成机器翻译任务

机器翻译 翻译句子xxx从一种语言(源语言)到句子yyy另一种语言(目标语言)。下面这个例子就是从法语转换成为英文。 统计机器翻译 英文是Statistical Machine Translation (SMT)。核心思想是从数据中学习概率模型...

分对话系统和机器翻译两部分 data为数据集 model为训练的模型 translation文件夹下又分了Seq2Seq和transformer两个模型,大家按需查看使用 以transformer文件夹为例,attention.py主要实现了注意力机制,...

本项目开发了一个集机器翻译与人工翻译于一体的翻译网站,以机器翻译为主要实现方向,通过整合人工翻译的结果形成训练 语料,使用在线模型训练功能结合训练语料对后台的机器翻译模型不断进行训练优化,该网站共包含...

https://mp.weixin.qq.com/s?__biz=MzI3MTA0MTk1MA==&mid=2651999438&idx=1&sn=9ede16ab3de8ded3b603870ba988f8e0 ... 通常来说,主流序列传导模型大多基于 RNN 或 C

摘要: - 数据准备:构建大规模平行语料,分词和清洗。划分训练、验证和测试集。 - 模型构建:使用预训练BERT作为...- 通过BERT表示学习,可以建立高效的机器翻译模型。 - 按步骤实现,不断优化,是获得好的翻译效果的关键。

本文提出的模型可以同时完成两项工作: 对齐 翻译 对齐是软对齐,用的是Attention机制来实现。 要把Attention机制中的QKV和本文的notation结合起来看。

原文地址:http://blog.csdn.net/young_gy/article/details/73412285#优化seq2seq语言模型传统的语言模型基于RNN的语言模型机器翻译基于统计的机器翻译架构基于RNN的seq2seq架构seq2seq结构优化seq2...

在上一篇博客中,我们介绍了 基于Seq2Seq模型的机器翻译。今天,在此基础上,对模型加入注意力机制Attention。 模型结构 首先,我们先了解一下模型的结构,基本与Seq2Seq模型大体一致: 首先,第一部分是编码器...

本次NMT task为英文翻译为中文, 参考指标为BLEU(暂定). 实验报告(pdf) 源码; tensorboard日志文件 test2数据集结果(格式应和test1中文数据集相同). 实验报告至少应该包括: 预处理过程, 模型结构, 超参数配置, 评估...

推荐文章

- Android RIL框架分析-程序员宅基地

- Python编程基础:第六节 math包的基础使用Math Functions_ps math function-程序员宅基地

- canal异常 Could not find first log file name in binary log index file_canal could not find first log file name in binary-程序员宅基地

- 【练习】生成10个1到20之间的不重复的随机数并降序输出-程序员宅基地

- linux系统扩展名大全,Linux系统文件扩展名学习-程序员宅基地

- WPF TabControl 滚动选项卡_wpf 使用tabcontrol如何给切换的页面增加滚动条-程序员宅基地

- Apache Jmeter常用插件下载及安装及软硬件性能指标_jmeter插件下载-程序员宅基地

- SpringBoot 2.X整合Mybatis_springboot2.1.5整合mybatis不需要配置mapper-locations-程序员宅基地

- ios刷android8.0,颤抖吧 iOS, Android 8.0正式发布!-程序员宅基地

- 【halcon】C# halcon 内存暴增_halcon 读二维码占内存-程序员宅基地